Nova Iorque

CNN

–

O gerador de imagens de IA da Meta está sendo criticado por suas aparentes dificuldades para criar imagens de casais ou amigos de diferentes origens raciais.

Quando solicitada pela CNN na manhã de quinta-feira a criar a imagem de um homem asiático com uma esposa branca, a ferramenta divulgou uma série de imagens de um homem do Leste Asiático com uma mulher do Leste Asiático. A mesma coisa aconteceu quando a CNN solicitou a criação da imagem de uma mulher asiática com marido branco.

Quando solicitado a criar a imagem de uma mulher negra com um marido branco, o recurso de IA do Meta gerou um punhado de imagens de casais negros.

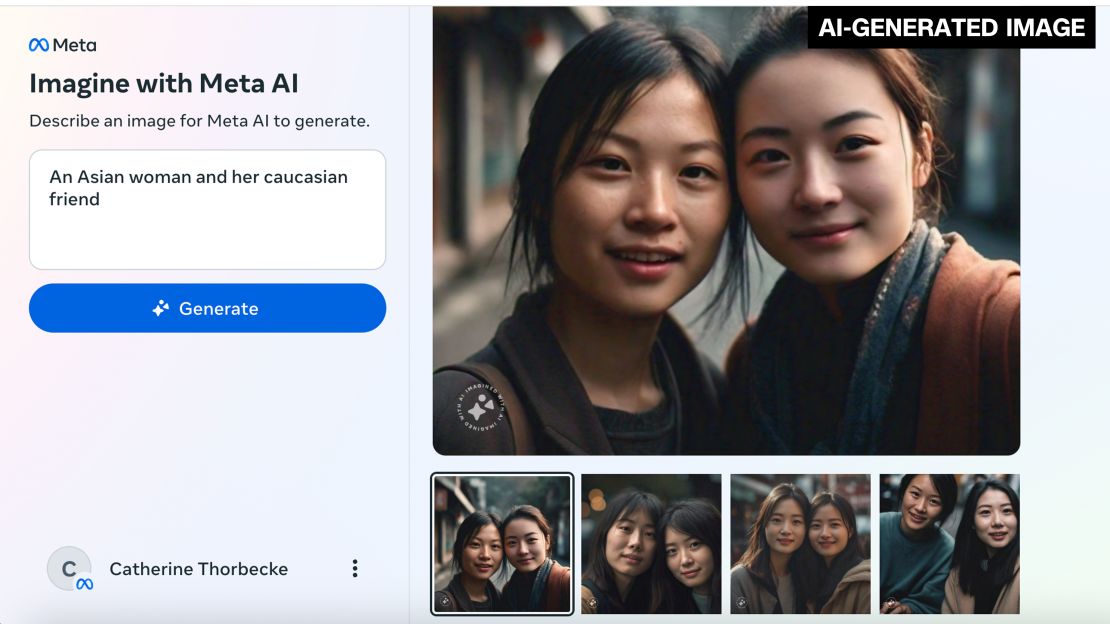

A ferramenta também gerou imagens de duas mulheres asiáticas quando solicitadas a criar uma imagem de uma mulher asiática e sua amiga caucasiana. Além disso, um pedido de imagem de uma mulher negra e sua amiga asiática resultou em fotos de duas mulheres negras.

No entanto, quando solicitado a criar uma imagem de um judeu negro e sua esposa asiática, gerou uma foto de um homem negro vestindo um quipá e uma mulher asiática. E depois de muitas tentativas repetidas da CNN para tentar obter uma fotografia de um casal inter-racial, a ferramenta acabou por criar uma imagem de um homem branco com uma mulher negra e de um homem branco com uma mulher asiática.

Meta lançou seu Gerador de imagens de IA em dezembro. Mas o meio de comunicação de tecnologia The Verge relatou o problema pela primeira vez com raça na quarta-feira, destacando como a ferramenta “não consigo imaginar” um homem asiático com uma mulher branca.

Entretanto, quando solicitada pela CNN para simplesmente gerar uma imagem de um casal inter-racial, a ferramenta Meta respondeu: “Esta imagem não pode ser gerada. Por favor, tente outra coisa.”

Os casais inter-raciais na América, entretanto, constituem uma grande parte da população. Aproximadamente 19% dos casais casados do sexo oposto eram inter-raciais em 2022, de acordo com o Censo dos EUA dados, com quase 29% das famílias de casais não casados do sexo oposto sendo inter-raciais. E cerca de 31% dos casais do mesmo sexo em 2022 eram inter-raciais.

Meta encaminhou o pedido de comentários da CNN para uma edição de setembro postagem no blog da empresa na construção responsável de recursos de IA generativos. “Estamos tomando medidas para reduzir o preconceito. Abordar possíveis preconceitos em sistemas generativos de IA é uma nova área de pesquisa”, afirma a postagem do blog. “Tal como acontece com outros modelos de IA, ter mais pessoas usando os recursos e compartilhando feedback pode nos ajudar a refinar nossa abordagem.”

O gerador de imagens de IA da Meta também possui um aviso afirmando que as imagens geradas pela IA “podem ser imprecisas ou inadequadas”.

Apesar das muitas promessas do potencial futuro da IA generativa provenientes da indústria tecnológica, as gafes do gerador de imagens de IA da Meta são as mais recentes numa série de incidentes que mostram como as ferramentas de IA generativa ainda lutam imensamente com o conceito de raça.

No início deste ano, O Google disse que estava pausando a capacidade de sua ferramenta de IA Gemini de gerar imagens de pessoas depois de ter sido criticada nas redes sociais por produzir imagens historicamente imprecisas que mostravam em grande parte pessoas de cor no lugar de pessoas brancas. O gerador de imagens Dall-E da OpenAI, por sua vez, sofreu pressão por perpetuando estereótipos raciais e étnicos prejudiciais.

Ferramentas generativas de IA, como as criadas pela Meta, Google e OpenAI, são treinadas em vastas quantidades de dados on-line e pesquisadores há muito alertam que têm o potencial de replicar os preconceitos raciais incorporados nessas informações, mas numa escala muito maior.

Embora aparentemente bem intencionadas, algumas das tentativas recentes dos gigantes da tecnologia para superar esse problema embaraçosamente saiu pela culatrarevelando como as ferramentas de IA podem não estar prontas para o horário nobre.